苹果展示了一种名为 Apple Visual Intelligence 的 Apple Intelligence 全新搜索体验。它的外观和感觉与 Google Lens 类似,但它使用原生 iPhone 相机并直接内置于 Apple Intelligence 中。

此外,它似乎还使用第三方搜索提供商(如 Google、OpenAI 的 ChatGPT 和 Yelp)来获取搜索结果 – 具体取决于查询的类型。

它看起来是什么样的。以下是我从昨天的 Apple 发布会上截取的一些截图,如果你想看的话,可以从这个视频中大约 57 分钟的地方开始:

想买一辆你在散步时看到的自行车;拍下它的照片后,它显示“正在使用 Google 搜索…”:

不过,所提供的搜索结果示例看起来有些“经过篡改”:

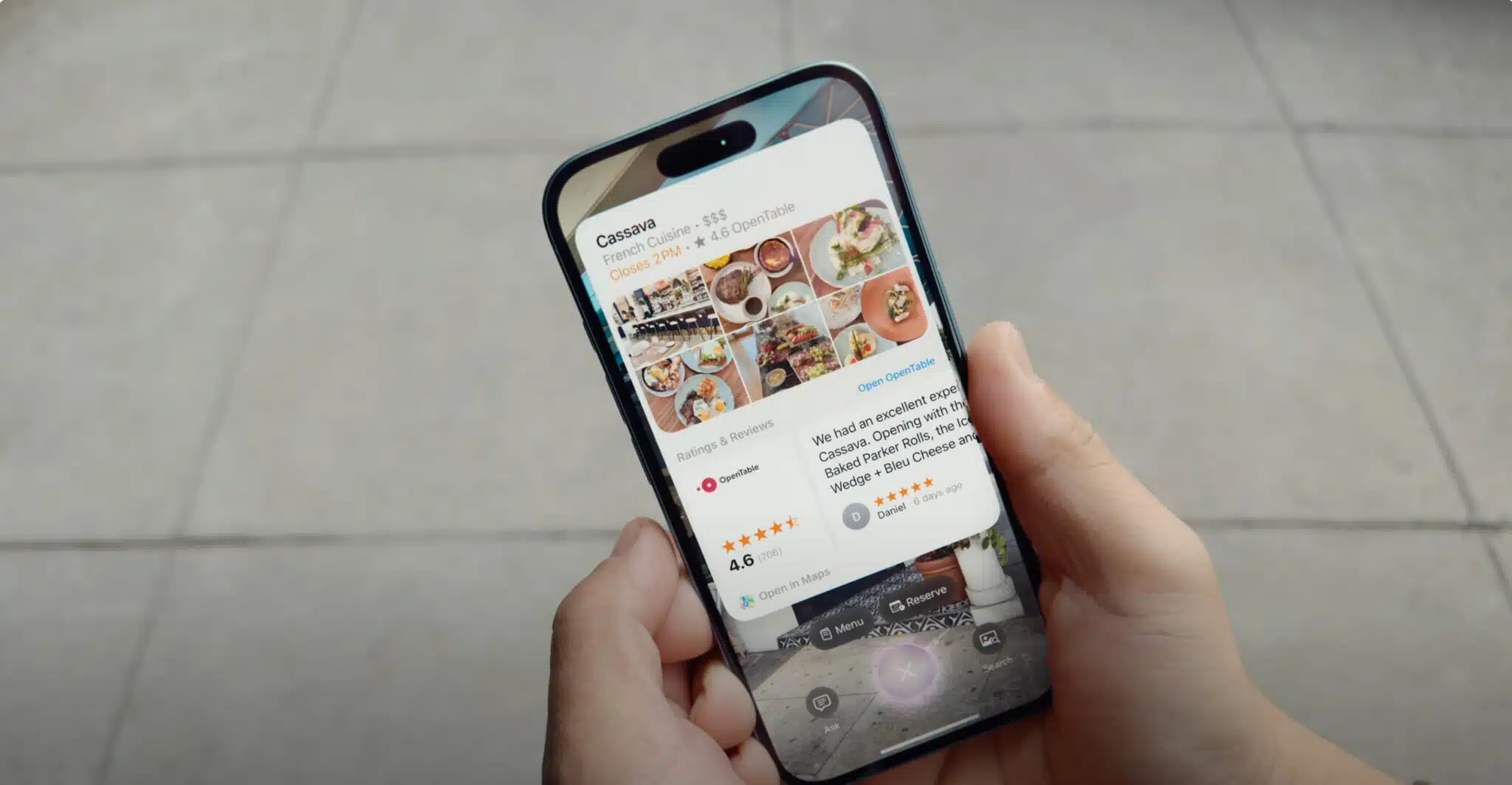

以下是当有人想了解他们在散步时遇到的餐厅的更多详情时显示的本地搜索结果示例。这似乎会调出 Apple Maps 中的本地搜索结果,我相信它是由 Yelp 和 OpenTable 提供支持的。

以下是 Apple Maps 中 OpenTable 选项的特写:

下面是一个拍摄家庭作业照片的示例,其中使用 OpenAI 的 ChatGPT 来帮助:

我们为什么关心这个问题。苹果似乎将人工智能作为工具,而不是其设备的基础,它与谷歌、OpenAI 和其他搜索提供商进行了集成。苹果设备上显然正在强调人工智能和机器学习,但结果似乎来自第三方。

《华盛顿邮报》的早期测试版评论表明,它还有很长的路要走。具体来说,它存在幻觉问题、将垃圾邮件标记为优先级等问题。